Dù trí tuệ nhân tạo (AI) hiện nay có thể mô phỏng ngôn ngữ của con người một cách ấn tượng, nhưng các tương tác trực tiếp của robot thường khá vô hồn và có phần đáng sợ, lý do nằm ở việc robot không thể sao chép được các biểu hiện và thái độ phi ngôn ngữ phức tạp mà rất quan trọng trong giao tiếp.

Xem xét vấn đề này, nhà nghiên cứu Hod Lipson tại Đại học Columbia ở New York và các đồng nghiệp đã tạo ra một robot mang tên Emo sử dụng các mô hình trí tuệ nhân tạo và camera độ phân giải cao để dự đoán, mô phỏng theo biểu cảm khuôn mặt của người. Emo có thể dự đoán một nụ cười trong 839 mili giây và bắt chước theo cùng lúc.

Các nhà khoa học đánh giá đây là một bước tiến trong việc giúp cho robot hình người (humanoid robot) trở nên chân thực và tự nhiên hơn đối với con người.

Theo nghiên cứu, tồn tại hai thách thức trong quá trình triển khai mô hình Emo. Thứ nhất là thách thức cơ học về việc động cơ hóa một khuôn mặt robot linh hoạt trong việc biểu hiện cảm xúc. Thứ hai là việc lựa chọn biểu cảm gì để robot trở nên tự nhiên, hợp thời điểm và chân thật.

Eva, robot trước đó của nhóm nghiên cứu, là một trong những nền tảng đầu tiên có khả năng tự mô hình hóa biểu hiện của mình. Tuy nhiên, để thực hiện được một tương tác xã hội chân thật hơn, robot cần dự đoán được biểu hiện gương mặt của người tham gia trò chuyện bên cạnh việc thực hiện biểu cảm của chính mình.

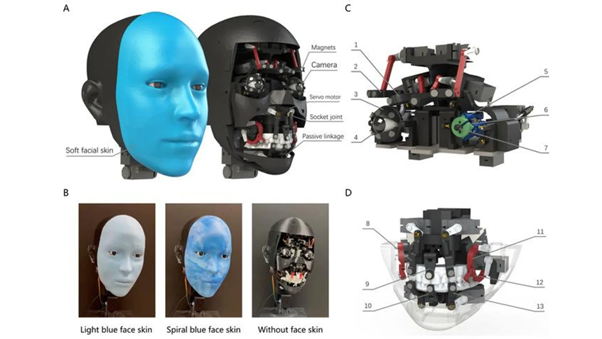

Đó là lý do nhóm cho ra đời Emo, một robot hình người tiên tiến vượt qua nền tảng của robot tiền nhiệm. Với 26 bộ truyền động, robot thực hiện các biểu hiện bất đối xứng thông qua những nam châm được gắn trực tiếp giúp tăng độ chính xác. Ngoài ra, các camera độ phân giải cao được gắn trong mắt nhằm quan sát hình ảnh con người, hỗ trợ việc dự đoán biểu hiện khuôn mặt của người đối diện.

Cấu tạo của bên trong của robot Emo. Ảnh: Interesting Engineer

Cấu tạo của bên trong của robot Emo. Ảnh: Interesting Engineer

Các nhà nghiên cứu cho biết, robot Emo sử dụng một khung nhị phân mạng nơ-ron nhân tạo để dự đoán biểu cảm khuôn mặt của chính nó và người tham gia trò chuyện trong cùng một thời điểm. Với 23 động cơ cho khuôn mặt và ba động cơ cho chuyển động cổ, cùng các nâng cấp phần cứng và một mô hình nghịch đảo cho phép tạo lệnh nhanh gấp năm lần, Emo đã cải thiện đáng kể khả năng tương tác.

Ngoài ra, Emo được vận hành theo hai mô hình AI, một mô hình dự đoán nét mặt của con người bằng cách phân tích những thay đổi tiểu tiết trên gương mặt người đối diện, và một mô hình tạo ra các lệnh cơ học bằng cách áp dụng các biểu cảm tương ứng.

Để huấn luyện robot, các nhà nghiên cứu đặt Emo trước camera và thực hiện các chuyển động ngẫu nhiên. Sau vài giờ, robot đã học được mối liên hệ giữa các biểu hiện khuôn mặt với các lệnh động cơ, tương tự cách con người luyện tập biểu cảm khuôn mặt khi nhìn vào gương. Nhóm gọi đây là phương pháp "tự làm mẫu", giống với khả năng tưởng tượng của con người về việc mình trông như thế nào khi thực hiện một số biểu cảm nhất định.

Sau đó, nhóm cho Emo xem những video về biểu cảm khuôn mặt của con người để theo dõi từng khung hình. Kết thúc quá trình huấn luyện kéo dài vài giờ, Emo có thể dự tính các biểu hiện khuôn mặt của con người bằng cách quan sát những thay đổi nhỏ trên khuôn mặt khi một người có ý định cười.

Kết quả cho thấy Emo có khả năng tiên đoán một nụ cười trong khoảng 839 mili giây trước khi được thực hiện. Bên cạnh đó, bằng cách sử dụng một mô hình tự động học, robot có thể đồng bộ nụ cười của mình với người mà nó giao tiếp.

Nhóm nghiên cứu kỳ vọng công nghệ của Emo sẽ cải thiện các tương tác giữa con người và robot. Nhưng họ cũng cho rằng trước hết cần phải mở rộng phạm vi các biểu cảm mà robot có thể thực hiện, cũng như khả năng tạo ra các biểu cảm phản ứng trước điều người khác nói, thay vì đơn giản là bắt chước nét mặt của một người.

Hà Anh/Sở hữu Trí tuệ và Nhân tạo